部署方案

为满足不同阶段技术需求,我们提供两种专业化部署方案:标准化 API 服务(免费版)和高性能 SDK 套件(企业级)。技术验证阶段优先采用 API 服务完成基础验证,业务规模化阶段通过 SDK 方案实现生产级性能优化。

一、标准化 API 服务(免费版)

核心特性

- 即装即用集成

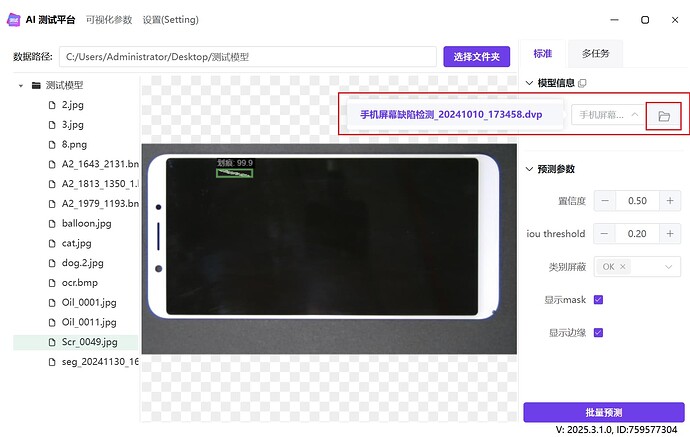

内嵌于AI测试平台的自动化接口服务,模型加载成功后自动生成标准化API,支持实时调用验证。 - 跨平台兼容设计

基于HTTP协议的标准化接口,无缝对接C/C#/C++/Python/Java/Go等主流开发框架。

适用场景

- 算法原型效果验证

- 多版本模型横向比对

- 系统集成兼容性测试

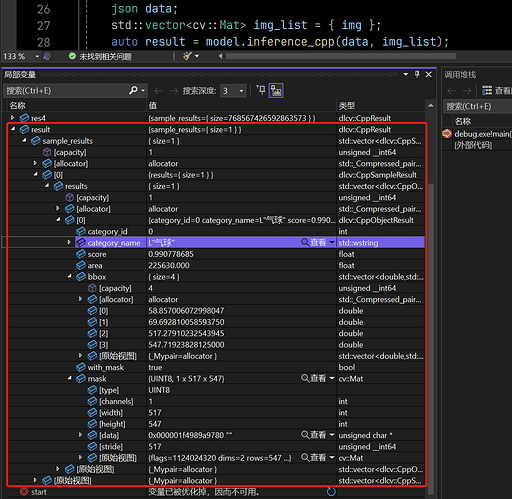

二、高性能 SDK 套件(企业级)

我们的 AI 模型推理框架是专为工业级部署设计的核心基础设施,深度融合C/C++高性能计算生态与NVIDIA GPU加速技术,为计算机视觉等AI场景提供毫秒级实时推理能力,在严苛的工业场景中验证了框架的可靠性和性能优势。

标准化API服务(免费版)

使用流程

graph TD

A[打开测试平台] --> B[加载模型]

B --> C[通过API调用推理接口]

使用流程

更新版本

将AI测试平台更新到 2025.3.1 以上的版本:

加载模型

调用API

import base64

import json

import requests

session = requests.session()

url = 'http://127.0.0.1:9890/api/inference'

model_path = r"C:\Users\Administrator\Desktop\测试模型\手机屏幕缺陷检测_20241010_173458.dvp"

img_path = r"C:\Users\Administrator\Desktop\测试模型\Scr_0049.jpg"

print(f'推理图片:{img_path}')

with open(img_path, 'rb') as f:

img_base64 = base64.b64encode(f.read()).decode()

data = {'model_path': model_path, 'img': img_base64}

response = session.post(url, json=data)

result = response.json()

print(json.dumps(result, indent=2, ensure_ascii=False))

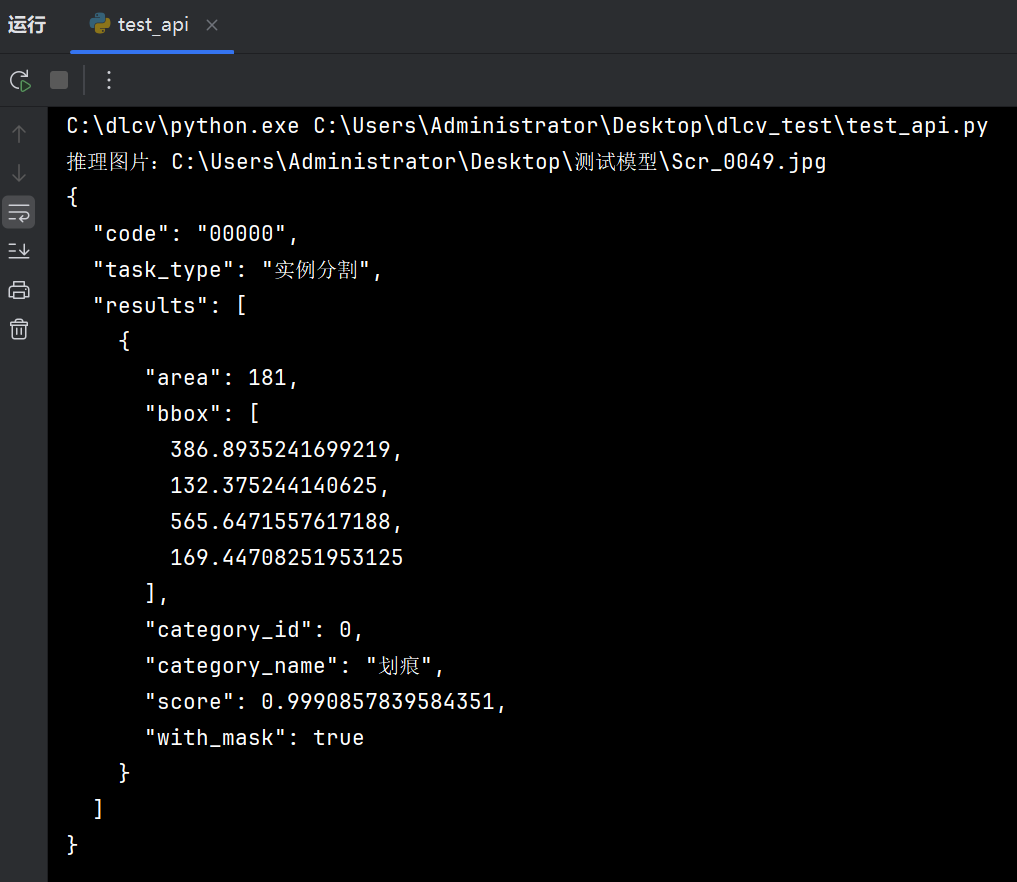

返回结果

{

"code": "00000",

"task_type": "实例分割",

"results": [

{

"area": 181,

"bbox": [

386.8935241699219,

132.375244140625,

565.6471557617188,

169.44708251953125

],

"category_id": 0,

"category_name": "划痕",

"score": 0.9990857839584351,

"with_mask": true

}

]

}

接口文档

输入

输入样例:

{

"img": "iVBORw0KG...",

"model_path": ""

}

- img,图像文件的base64编码

- model_path,模型路径

输出

输出样例:

{

"code": "00000",

"task_type": "目标检测",

"results": [

{

"bbox": [

231.56,

375.28,

247.95,

409.23

],

"category_id": 1,

"category_name": "划痕",

"score": 0.9918314814567566,

"with_mask": false

}

]

}

- code:状态码,字符串,00000 代表成功

- task_type,模型类型,字符串

- message:消息,字符串,提示信息

- results:识别结果

- area:面积,整数,如果是实例分割模型才有面积输出

- bbox:检测框的结果,浮点数列表,格式是 x1, y1, x2, y2,检测类的模型有检测框结果输出

- category_id:类别索引,整数

- category_name:类别名称,字符串

- with_mask:是否返回了 mask,布尔类型

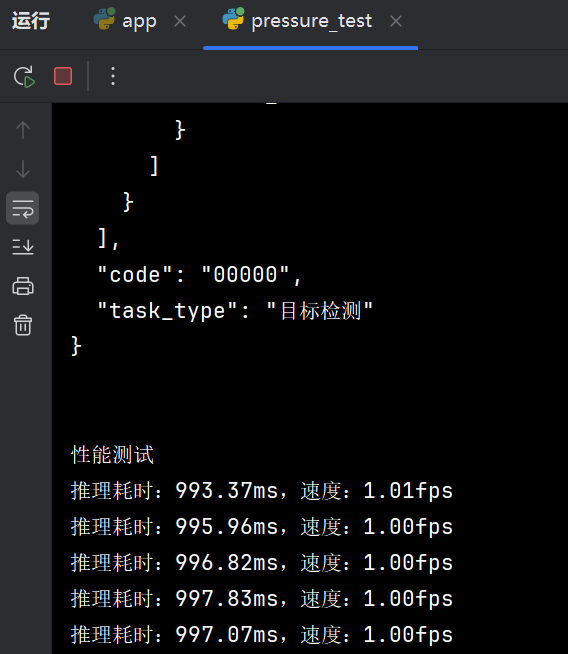

速率限制

如果突发速率不超过100张图,则速度可以维持满速:

当接口触发速率限制之后,会变为1fps: